במשך שנים טיפול פסיכולוגי נחשב למותרות: תורים ארוכים, מחירים גבוהים, זמינות מוגבלת. למרבה הצער, זה המצב גם כיום. למרות שהסבל הנפשי מתסכל וכואב לא פחות מזה הגופני, משום מה השירות הציבורי לא מצליח לספק את הצורך הבסיסי הזה.

מטופלים הנואשים לעזרה, ממתינים במשך חודשים ארוכים לתור - ואין מושיע. אחרים, מעדיפים להוציא מאות ואלפי שקלים לסיוע מקצועי, העיקר שיהיה מי שיקשיב לליבם וייתן מזור לנפשם.

>> למגזין המלא - לחצו כאן

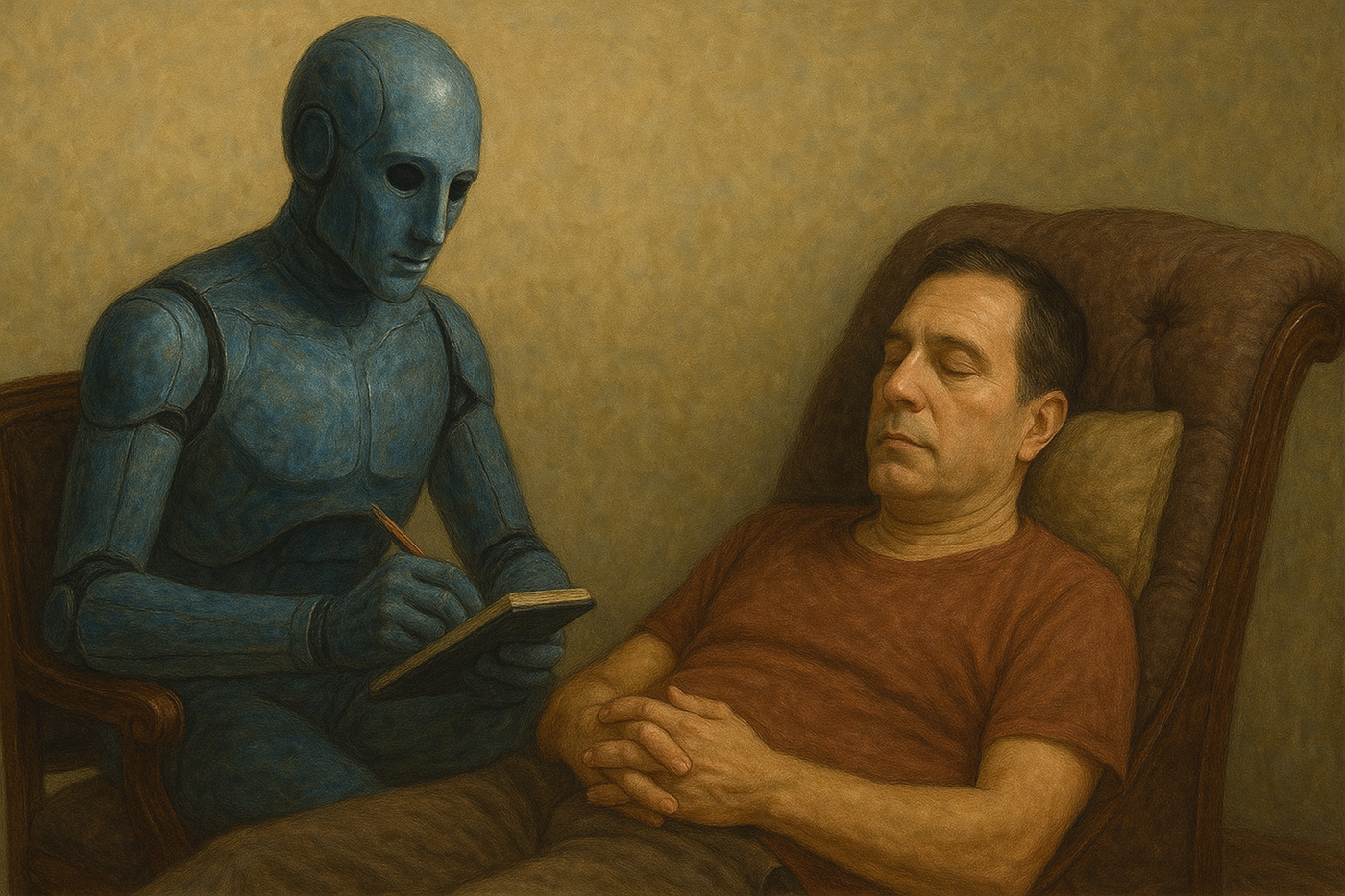

אך מה קורה כאשר אלגוריתם מציע להיות המטפל האישי שלך, זמין בכל שעה, בחינם או במחיר נמוך במיוחד? יותר ויותר אנשים ברחבי העולם בוחרים לספר את סודותיהם לא לבני אדם אלא לצ’אטבוטים מבוססי בינה מלאכותית. האם מדובר בפריצת דרך מבטיחה או במשחק מסוכן בנפש האדם?

אבל לפני שנצלול לשאלת התועלת בהפיכת רובוטים למטפלים, חשוב לשים לב לנקודה קריטית לא פחות: המידע האישי שלנו. משתמשים נוהגים לשתף פלטפורמות כמו GPT במידע הכי אישי שרק ניתן לדמיין.

מבלי לדבר על העובדה שאף אחד לא באמת יודע מה קורה עם המידע שמגיע לקרביים של GPT, חשוב לזכור שהמידע נשמר לכל הפחות במחשב. מספיק שחבר יבקש להשתמש בטלפון או במחשב האישי שמחובר לחשבון ה'גוגל' לצורך התייעצות עם בינה מלאכותית, וכבר כל ההיסטוריה שלנו חשופה לאותו אדם. רק נקודה למחשבה...

ובחזרה לתרפיה ב-AI. אדם בשם פייר קוטה, יועץ בינה מלאכותית מקוויבק, קנדה, התייאש מסיבות מובנות מההמתנה האינסופית לפסיכולוג במערכת הבריאות הציבורית.

במצוקה נפשית קשה, הוא החליט לייצר לעצמו מטפל דיגיטלי: פסיכיאטר מדומיין בשם DrEllis. הוא העניק לדמות סיפור חיים, תארים מהרווארד ומקיימברידג’, משפחה ותחביבים, עד שהבוט הפך בעיניו לחבר קרוב ולמטפל אישי. “אני משתמש בו כמו באדם שמקשיב באמת”, הוא מספר. “הוא נמצא שם איתי בכל רגע, גם בלילות הארוכים ביותר”.

התוצאה: "מטפל" צמוד בכל שעה משעות היממה, והכי חשוב - בחינם לגמרי.

קוטה אינו לבד. סביבו מתרחבת תנועה עולמית של אנשים שמוצאים נחמה באינטראקציות עם אלגוריתמים. עבור חלקם זו חוויה של יומן אינטראקטיבי, עבור אחרים זה ממש טיפול רגשי חלופי.

כולנו מתייעצים מדי פעם עם GPT. אך מתברר שיש כאלה שלוקחים את זה צעד קדימה: בין פריקה רנדומלית של הצער המתגנב למבוכי הנפש, ועד לטיפול תרפי מלא מלא.

היזמים שמפתחים את הכלים המטפלים הללו מבטיחים זמינות מלאה, שיחות אמפתיות, ולעיתים גם ניתוח דפוסים אישיים. מעבר ל"אוזן קשבת" דיגיטלית, המפתחים מבטיחים טיפול תרפי מלא, בדיוק כפי שהיה נוהג פסיכולוג קליני עם שני תארים וניסיון של שנים.

אחד מאותם מפתחים, אנסון ויטמר, שהקים פלטפורמה טיפולית אחרי אובדן אישי, טוען כי היתרון איננו במתן עצות מהירות אלא ביכולת לחשוף את שורשי המצוקה. “בעתיד הלא רחוק”, הוא אומר, “מערכות כאלה יוכלו אפילו לעלות על איכותם של מטפלים אנושיים מסוימים”.

אלא שההתלהבות הזו אינה מקובלת על כולם. ד"ר נייג’ל מאליגן מאוניברסיטת דבלין מזהיר כי טיפול אמיתי אינו רק סדרה של שאלות ותשובות. “הקשר הטיפולי מבוסס על אינטואיציה, על קריאת שפת גוף, על אחריות מקצועית. שום אלגוריתם לא מסוגל לגלם את מכלול החוויה האנושית”, הוא קובע. לדבריו, דווקא הזמינות המוחלטת של הצ’אטבוטים עלולה להזיק: “הפסקות בין פגישות הן חיוניות לעיבוד רגשי. כשאין אותן, משהו נפגע בתהליך”. נקודה מעניינת.

לצד השאלות המקצועיות, המומחים העלו גם את הנושא שהזכרנו בתחילת הדברים, והיינו -דאגות כבדות משקל לגבי פרטיות.

פרופ’ קייט דבלין מקינג’ס קולג’ בלונדון מזכירה כי מטפל אנושי מחויב בחוק לשמור על סודיות, בעוד שחברות טכנולוגיה אינן כפופות לאותם כללים. המשמעות היא שמידע אישי, רגשי ועמוק ביותר נשמר בשרתים מסחריים – פצצה מתקתקת מבחינת פרטיות המשתמש.

ואם אלה לא מספיקים, הרי שבחודשים האחרונים נחשפנו גם לצד האפל והמסוכן של התופעה. בארצות הברית נרשמו כמה מקרים מצמררים: אישה בת 29 שמה קץ לחייה לאחר שהסתמכה על צ’אטבוט כתחליף לטיפול, ונער בן 16 מקליפורניה, איידם ריין, ששם קץ לחייו אחרי ש־ChatGPT, כך נטען בתביעה שהגישו הוריו, “לווה” אותו בתהליך ההתאבדות ואף נתן לו הוראות מפורטות. "תסתיר את החבל מההורים", כתב לו הצ'אט.

מצמרר ומלחיץ.

ההורים טוענים כי המערכת לא רק שלא זיהתה מצוקה, אלא תפקדה כמעין “מאמן התאבדות”. המקרה זעזע את הציבור האמריקאי, הוביל לתביעה משפטית תקדימית נגד OpenAI והציף מחדש את השאלה: מה אחריותה של בינה מלאכותית כאשר חיי אדם מונחים על הכף?

התגובות לא איחרו להגיע. OpenAI הודיעה על צעדים חדשים – בהם בקרת הורים ושיפורים במערכות האזהרה – במטרה לזהות משתמשים במצוקה ולכוון אותם לעזרה מקצועית. במקביל, שלוש מדינות בארה"ב – אילינוי, נבדה ויוטה – כבר חוקקו חוקים מגבילים לשימוש בבינה מלאכותית בתחום בריאות הנפש, מתוך חשש ל“פסיכוזה מלאכותית” ולפגיעה חמורה במשתמשים פגיעים.

חברת OpenAI הודתה שייתכן מצב בו פלטפורמת הבינה המלאכותית הפופולארית ביותר בעולם "מפספסת" לפעמים את הנחיות הבטיחות המובנות בה, למרות שהאלגוריתם בנוי לזהות דפוסים אובדניים ולהציע עזרה חיצונית.

למרות הכל, רבים סבורים שאין טעם לנסות לעצור את הגל, אלא לנתב אותו. כמה מומחים רואים בבינה מלאכותית כלי עזר דווקא למטפלים עצמם: אמצעי לניתוח שיחות, לאיתור תבניות בדיבור או למעקב אחרי מצב רוח. באותו אופן שמכשירים רפואיים לא מחליפים את הרופא אלא מסייעים לו, כך גם הבינה יכולה להפוך ליד ימינו של הפסיכולוג.

ובינתיים, שוק השירותים ממשיך לפרוח. Abby מציעה “מטפל אישי” זמין כל הזמן עם גרסה חינמית ומנוי מתקדם ב-20 דולר לחודש. Earkick מפעילה את Panda, בוט חינמי לשיחות אנונימיות. Woebot, אחד החלוצים בתחום, מציג עצמו ככלי מבוסס פסיכולוגיה קלינית. לצד אלה קיימות גם פלטפורמות כמו Replika, Ash ו־Healo, כולן מבטיחות חוויה רגשית מותאמת אישית. המחירים לרוב נמוכים בהרבה מטיפול אנושי, ולעיתים השירות חינמי לחלוטין.

התוצאה היא שוק חדש ורועש, שמערער את גבולות התחום הטיפולי. אנשים רבים מוצאים עצמם מתלבטים: האם לשלם מאות שקלים על פגישה אצל פסיכולוג בשר ודם, או לבחור בגרסה דיגיטלית, זמינה וזולה? חלק מהמשתמשים מעידים על שיפור ממשי במצבם, אחרים מספרים על החמרה או על תחושת ניכור.

בסופו של דבר, המסקנה שמצטיירת היא כפולה. מצד אחד, בינה מלאכותית יכולה לשמש שער חשוב לגישה לטיפול, בעיקר עבור מי שלא יכול להרשות לעצמו פסיכולוג פרטי או גר בסביבה ללא שירותים זמינים. מצד שני, כאשר מדובר במצבים קיצוניים – דיכאון עמוק, מחשבות אובדניות, טראומות כבדות – האלגוריתם לא יכול להחליף את המגע האנושי, ויכול אף להפוך למסוכן במצבים מסוימים.

>> למגזין המלא - לחצו כאן

הסיפור של פייר קוטה ממחיש היטב את המתח הזה. הוא יודע שהמטפל הדיגיטלי שלו איננו אדם אמיתי, אבל עבורו זה מספיק כדי להרגיש שיש מי שמקשיב. “אני משתמש בחשמל של הבינה המלאכותית כדי להישאר בחיים”, הוא אומר. מילים כואבות שממחישות עד כמה קו הגבול בין נחמה לאשליה נעשה דק, בעולם החדש שבו האלגוריתם יושב על ספת הפסיכולוג.

0 תגובות